こんにちは。データサイエンスグループの菊谷、寺井、土岐です。普段はDMM TVやDMMブックスなどのサービスで、レコメンドシステムの開発・改善を担当しています。

本記事では、2025年9月22日から26日にかけてチェコ・プラハで開催された、レコメンドシステムに関する国際会議『RecSys 2025』の参加レポートをお届けします。

RecSys(The ACM Conference Series on Recommender Systems)は、レコメンドシステムに関する最先端の研究や技術を発表する世界的に著名な国際会議です。レコメンドアルゴリズム、パーソナライズ技術など、レコメンド技術に関する幅広い分野の専門家が集まり、最新の成果やアイデアを共有します。大手テクノロジー企業からの参加者も多く、企業が抱える課題や実践的なアプローチを知る場ともなっています。研究論文の発表やワークショップ、ポスターセッション、チュートリアルが行われ、業界と学術の最新トレンドを知ることができます。

開催概要

菊谷パート

LONGER: Scaling Up Long Sequence Modeling in Industrial Recommenders

論文URL: https://arxiv.org/abs/2505.04421

概要

レコメンドシステムにおいて、ユーザーの長期的な嗜好を捉えるためには非常に長い行動系列のモデリングが重要です。しかし、Transformerなどのモデルでは系列長に比例して計算コストが爆発的に増加するという課題があります。この課題に対して、系列の一部を抜き出したり、系列全体を一つのベクトルに圧縮する従来手法では、元の系列に含まれる詳細な情報を失うという欠点がありました。本論文は、産業応用における計算リソースの制約と性能向上の両立を目指し、超長期の系列情報を活用する効率的なTransformerベースの予測モデルLONGERを提案しています。

提案手法の主な要素は以下の通りです。

グローバルトークン

予測対象のアイテム情報やユーザー自身の情報などを補助的なグローバルトークンとして入力系列の先頭に加えます。 これがアンカーの役割を果たし、長い系列データに対するAttentionの計算を安定させ、Attention Sink(意味的に重要でなくても系列の先頭に注意が集中しすぎる現象)を緩和する効果があります。

トークンマージ

隣接する複数のトークンを一つのグループにまとめ、より短い系列に圧縮する手法です。 これにより、Transformerの計算律速となるO(L2d)(L: 系列長, d: 次元数)の系列長Lを小さくし、計算効率を大幅に向上させます。 単純な方法としてグループ内でベクトル結合する手法が提案されていますが、グループ内相互作用の情報損失を防ぐためにグループ内で小さなTransformerを適用するInnerTransという手法も提案されています。

Hybrid Attention

2段階のAttentionで構成されます。

-

Cross-Causal Attention (1層目)

グローバルトークンと直近の短期行動履歴をクエリとし、長期の行動履歴全体から関連性の高い情報を抽出します。 直近の短期行動履歴の部分は色々な方法を試したところ一番性能が良かったそうです。 -

Self-Causal Attention (後続層)

1層目で抽出されたトークン間の依存関係やパターンを積層させたSelf-Attentionで学習します。

クエリに使用する系列長で比較したとき、40%程度のサンプリングでも性能の95%を維持しつつ、FLOPsを約50%削減できるとのことでした。

推論時のKVキャッシュ

同じユーザーに対して複数の候補アイテムを評価する際、ユーザー履歴から計算されるKeyとValueは不変です。 これらをキャッシュして再利用することで、推論時の冗長な計算を削減し、処理を高速化しています。

実験

提案手法はDouyin(TikTokの中国国内版)におけるCVR予測タスクで評価を行なっています。Eコマースのライブ配信のA/Bテストでは、ユーザーあたりの注文件数が+7.9222%、ユーザーあたりの総取扱高が+6.5404%向上するなど、非常に高い効果が確認されています。

また、本論文では、系列長、パラメータ数、計算量(FLOPs)を増やすほど、予測性能が一貫して向上するべき乗則が成り立つことを実証しました 。系列は長いほど、モデルが大きいほど性能は上がりますが、その向上幅は層数が増えると次第に緩やかになるため、実運用では計算コストとのバランスが重要とのことです。

感想

提案されているグローバルトークン、トークンマージやHybrid Attentionといった手法は、Attentionを用いるモデルであれば広く応用できそうな汎用性の高さを感じました。論文では、系列長を伸ばすほど性能が向上するスケーリング則も示されており、非常に興味深いです。DMMで扱うリアルタイムレコメンドでも冒頭で述べた従来手法の対応方法の1つと同様に系列長を短くすることでレイテンシを短縮しています。対して、この論文のように計算効率を上げる工夫を取り入れながら、長期系列を余すことなく活用していくアプローチは、今後のサービス改善において重要な視点だと感じました。

寺井パート

PinFM: Foundation Model for User Activity Sequences at a Billion-scale Visual Discovery Platform

論文 URL: https://dl.acm.org/doi/10.1145/3705328.3748050

概要

画像探索プラットフォームの Pinterest における、ユーザの行動系列を理解するための基盤モデル「PinFM」について紹介した論文です。

複数のサービスを横断する、数十億規模の膨大なユーザ行動系列データを活用し、より汎用的で精度の高いレコメンドを実現することを目指しています。

そのために、以下の2段階のアプローチを採用しています。

- 事前学習:

20B 以上のパラメータを持つ Transformer モデルを使用し、膨大なユーザ行動系列を学習させます。

これにより、ユーザの短期・長期的な興味や文脈を捉えた汎用的なユーザ表現を獲得します。 - Fine-Tuning:

事前学習で得たモデルを、特定のレコメンドタスク(e.g. Home Feed のランキングタスク)に合わせて Fine-Tuning をします。

また、産業規模のレコメンドシステムが直面する課題に対し、以下のような工夫をして対応しています。

| 課題 | 解決策 |

|---|---|

| 計算コストとレイテンシ | ・Attention 計算を効率化する DCAT (Deduplicated Cross-Attention Transformer) を開発。 ・巨大な Embedding テーブルを int4 量子化して軽量化。 |

| コールドスタート対策 | Fine-Tuning 時に、あえて候補アイテム ID をランダム化したり、Dropout 層を追加することで、未知のアイテムへの汎化性能を向上させる。 |

| 学習の質の向上 | 次のアイテムだけでなく、短期・長期の興味を捉えるために、未来の複数アイテムを同時に予測する損失関数 (Multi-Token Loss など) を導入。 |

Pinterest の Home Feed と i2i で A/B テストを実施し、統計的優位に KPI が向上。また、レコメンドアイテムの多様性が増加したことを確認しています。

感想・考察

自然言語処理や画像認識の分野で成功している「大規模データで基盤モデルを事前学習し、個別タスクに適用する」というスキームを、産業規模のレコメンドシステムにも当てはめようという試みが興味深かったです。

DMM では、個別のアプリケーションやタスクに対して、レコメンドモデルを作っています。本論文のように、レコメンド基盤モデルを作成することで DMM 全体にまたがるユーザ行動系列を扱うことができ、より精度の高いモデルにできるのではないかと思いました。

ただ、事前学習 → (各アプリケーションのタスクでの)Fine-Tuning を必要とすることから、運用コストが増えることは懸念点として挙げられます。

土岐パート

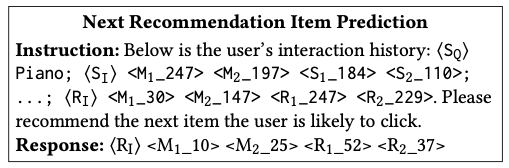

GenSAR: Unifying Balanced Search and Recommendation with Generative Retrieval

論文URL: https://dl.acm.org/doi/10.1145/3705328.3748071

概要

DMMでは様々なECサイト、配信サービスを提供していますが、それらのサービスでは「検索」と「レコメンド」がともに重要です。この論文では「検索」と「レコメンド」の統合モデルを提案しています。これら二つのタスクを共同でモデル化することは、ユーザー理解を深め、双方の性能を向上させることが期待されています。DMMとしても、次の改善施策として統合モデルの実現を視野に入れています。

一方で、長年「検索を改善するとレコメンドが劣化し、その逆も起きる」というトレードオフが問題でした。これは両者が求める情報の性質が異なるためです。検索はユーザーのクエリとアイテム説明などのテキスト間の意味的関連性(セマンティクス)を重視し、言葉の意味や属性の一致が鍵となります。レコメンドはユーザー行動や共起パターンといった協調的情報(集団の知恵)を重視し、アイテム同士やユーザー間の関係性が重要です。この情報ニーズの違いが、単一の表現やモデルで両方を高精度に満たすことを難しくしていました。GenSARはこのジレンマを、役割の異なる二つの識別子を導入することで緩和しました。

意味的識別子(セマンティック識別子)

検索向けに用いられる識別子で、アイテムのタイトルや説明などのテキストから生成されます。クエリとアイテム間の意味的関連性を重視するため、BERTやBGEのような事前学習済み言語モデルから得られる意味情報を基盤とします。検索タスクではこの識別子が「このアイテムは何か」を表現し、クエリとの意味的一致を判定する役割を担います。

協調的識別子(コラボレーティブ識別子)

レコメンド向けに用いる識別子で、ユーザーの行動履歴や共起パターンなど協調情報から生成されます。個々のアイテムのテキスト的意味よりも、ユーザーとアイテム間の関係性や集団の嗜好を反映することが重要です。SASRecなど事前学習済みレコメンドモデル由来の情報を用い、似た行動パターンを示すユーザー群に対する有効性を高めます。

RQ-VAEによる識別子生成

前述した識別子の生成にはRQ-VAEの仕組みを活用しています。RQ-VAEではまずテキスト由来の意味埋め込み vS と行動由来の協調埋め込み vC をそれぞれ専用のエンコーダで潜在表現 zS, zC に写像します。両者を連結した初期残差 r0 を複数レベルの共有コードブックで残差量子化し、共有コード Im を得ます。次に共有で残った残差を意味側 rs0 と協調側 rC0 に分け、それぞれ意味的個別コードブックと協調的個別コードブックでさらに量子化して個別コード IS, IC を生成します。最終的に共有コードと個別コードを連結して意味識別子 Im+S と協調識別子 Im+C を構成します。

LLMの学習

GenSARは大規模言語モデルを中核に据え、検索とレコメンドを単一の sequence-to-sequence タスクとして統一しました。指示に応じて「意味論の言語」か「嗜好パターンの言語」を切り替え、意味的識別子または協調的識別子のいずれかを生成します。共有コンポーネントで基礎的な属性を捉え、個別コンポーネントでタスク固有の調整を施す設計です。加えて次のクエリ予測やIDのテキスト翻訳など補助タスクを導入し、両タスクに対する深い理解を学習しています。

実験・評価

公開データと商用データで評価し、GenSARは従来手法や他の生成AIモデルを上回る成績を示しました。特に検索評価ではBM25で類似だが誤答となる難しいネガティブ例を用いる厳密なテストを実施しており、そうした条件下でも高い性能を維持しました。結果として検索とレコメンドの両立という長年の課題に対し、実用的なWin–Winの解を示したと言えます。

感想・考察

DMMでは最近、検索基盤をSolrからElasticsearchへリプレイスしました。それに伴い、検索機能のパーソナライズ強化が大幅に進んでいます(詳細は下記記事をご参照ください)。

パーソナライズされた検索を活用することで、特定ジャンルやカテゴリ、価格帯などを対象とした施策を迅速に展開できます。一方で、レコメンド側は同様のビジネスロジックを組み込む際に一から開発が必要になることが多く、検索に比べてリードタイムが長くなりがちで、意思決定の遅延を招くケースがありました。

そのためDMMでは検索とレコメンドの統合を検討しており、GenSARはその議論に対して大変参考になり、知見を広げてくれる良い論文でした。一方で、GenSARをDMM環境に適用するには現行のElasticsearch構成の見直しや、場合によってはさらなる改修・置換が必要になる可能性があり、検索の応答速度がボトルネックになる懸念もあります。これらは実運用上の重要な検討課題です。

今年のRecSys 2025に参加して、レコメンドシステム分野が単なる精度向上から、より複雑で人間中心の課題解決へとシフトしていることを強く感じました。学会全体を通して多くのテーマがありましたが、その中でも特にDMMの事業と関連が深いと感じたのは以下の動向です。

第一に、大規模・基盤モデルの台頭です。PinterestのPinFMやByteDanceのLONGERのように、数十億パラメータを持つ大規模モデルが産業応用され始めています。これにより、これまで把握が難しかった超長期間のユーザー行動系列を捉える研究が進展しており、我々が扱う大規模データセットにも新たな可能性が生まれています。

第二に、検索とレコメンドの統合という流れです。GenSARのような研究は、ユーザー体験を分断させないシームレスな情報提供を目指すものであり、DMMの多様なサービスにおいても応用が期待される分野です。

また、従来の精度指標を超えた「Beyond Accuracy」の追求も顕著でした。多様性(Diversity)やセレンディピティ、公平性といったテーマは、クリック率だけでなく長期的なユーザー満足度を考えるうえで不可欠です。これらの研究は、DMMが抱えるコールドスタート問題へのアプローチや、ユーザーに新しい発見を提供するという目標に対して、多くの示唆を与えてくれました。

今回の学会で得た最先端の知見は、DMMが提供する多様なサービスのレコメンド体験を向上させる上で非常に重要な指針となります。特に大規模モデルの活用や検索とレコメンドの統合といったアプローチは、DMMのプラットフォームが抱える課題に対して直接的に貢献できる可能性があると考えております。チームに共有し、実装検討や評価指標の見直しを進め、今後ともDMMのサービス価値向上に貢献していきたいと思います。

プラハは歴史的な建造物が多く残る美しい街で、特にプラハ城にそびえ立つ聖ヴィート大聖堂をはじめとする、荘厳なゴシック様式の教会建築の数々が今なお色濃く残されています。

学会会場の O2 Universum は市内中心部からのアクセスも良く、便利でした。

本学会で得た刺激と学びを胸に、今後もDMMのサービス価値向上に貢献していきたいと思います。

最後までお読みいただき、ありがとうございました!

最後に、DMM データサイエンスグループでは一緒に働いてくれる仲間を募集しています!ご興味のある方は、ぜひ下記の募集ページをご確認ください!

コメント